Groq ist da! 70x schneller und 200x günstiger als GPT-4

Groq könnte gerade die nächste KI-Revolution angestoßen haben, aber dieses Mal im Hardware-Bereich. Denn mit den eigens produzierten neuen Groq Halbleiter-Chips lassen sich Geschwindigkeiten für die Ausführung von Rechenoperationen von KI Sprachmodellen wie es z.B. GPT-4, Llama2, Mixtral 8x7b, Claude, usw. sind, in rasend schneller Geschwindigkeit und zu viel günstigeren Kosten ausführen.

Aktuell ist Groq mit den Open Source LLM (Large Language Models) Llama2 (von Meta) und Mixtral 8x7b (von Mistral) nutzbar. In diesem Artikel zeige ich dir, wie das geht und wie viel schneller Groq im Vergleich zu GPT-4 arbeiten kann.

Was ist Groq?

Groq ist ein Halbleiter-Hersteller, der eine Sprachverarbeitungseinheit (LPU - Language Processing Unit) entwickelt hat, die im Gegensatz zu bisherigerigen Grafikprozessoren (GPU - Graphic Proecssing Unit) deutlich schneller und effizienter rechnen kann, wenn es um die Verarbeitung von KI-Rechenoperationen geht.

Bisher geben Platzhirsche wie NVIDIA mit ihren Grafikchips wortwörtlich den Takt in der KI-Verarbeitungsgeschwindigkeit an. Mit den neuen Groq LPUs wurde nun die Messlatte für die natürliche Sprachverarbeitung von KI-Modellen (NLP - Natural Language Processing) aber deutlich noch oben verlegt.

Effizientere Rechenleistung = schnellere Ergebnisse = geringere Kosten

So kannst du Groq nutzen

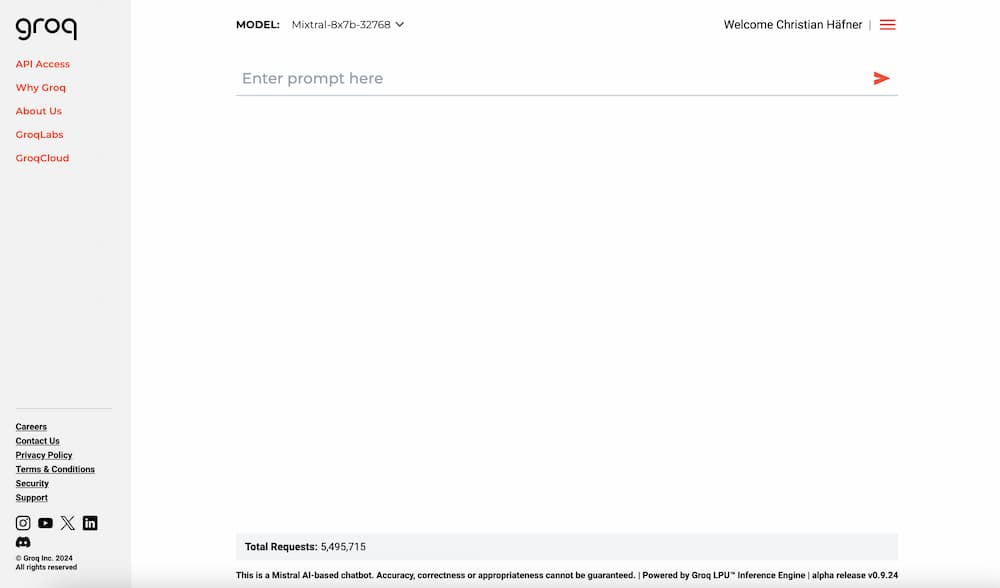

Melde dich auf groq.com einfach an und leg los. Die Anmeldung ist kostenlos!

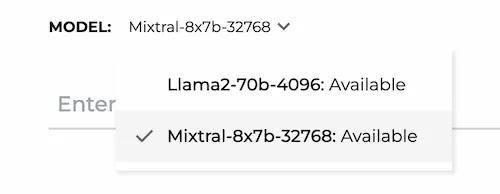

Zur Auswahl stehen derzeit zwei unterschiedliche Open Source LLMs:

- Llama 2 (von Meta)

- Mixtral 8x7b (von Mistral)

Auswählen kannst du das ganz oben unter Model und so auch beide direkt miteinander vergleichen, sowohl die Performance, als auch die inhaltliche Qualität.

Sobald du dich für ein Modell entschieden hast, fange einfach an zu prompten. Wie schnell die Antworten kommen, habe ich in diesem Video verglichen:

Groq Cloud

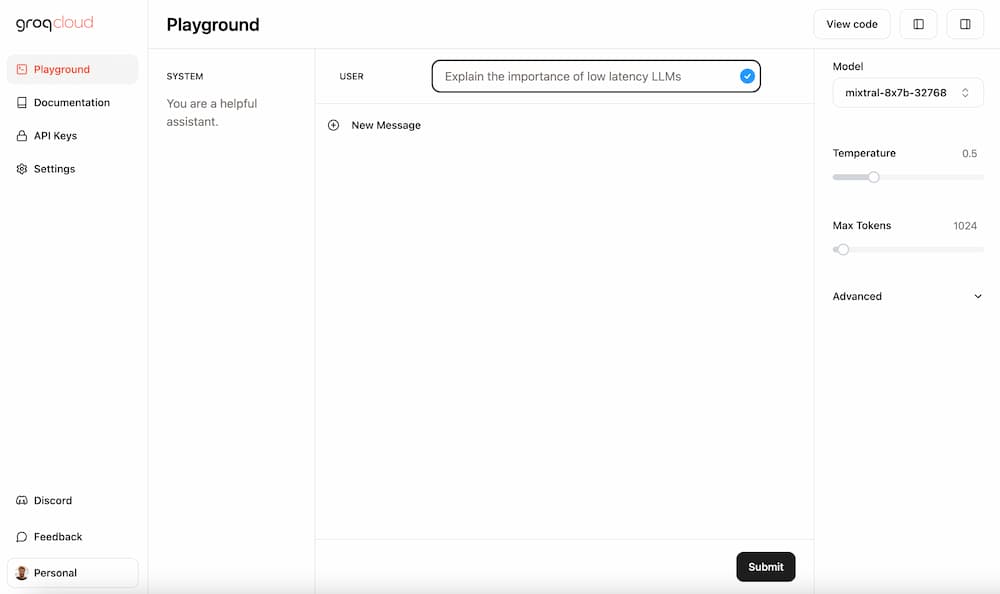

Neben der einfachen Chatoberfläche gibt es bei Groq auch die sogenannte Groq Cloud. Optisch und funktional erinnert dieses Tool bereits an OpenAI's Assistenten Oberfläche samt Playground.

Hier kannst du deinen Groq Chatbot konfigurieren und den Input/Output per API Schnittstelle abfragen. Der Zugang zur API muss derzeit noch angefragt werden und kann in den ersten 10 Tagen kostenlos genutzt werden.

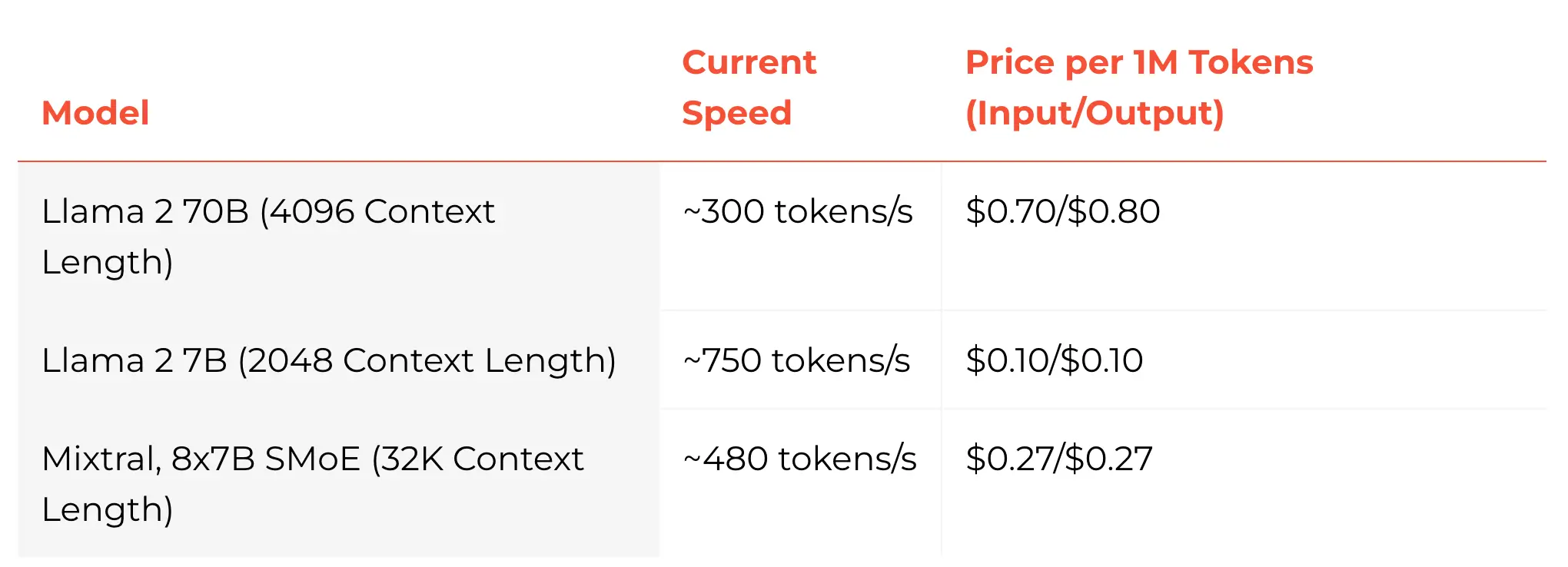

Danach bleibt es aber günstig:

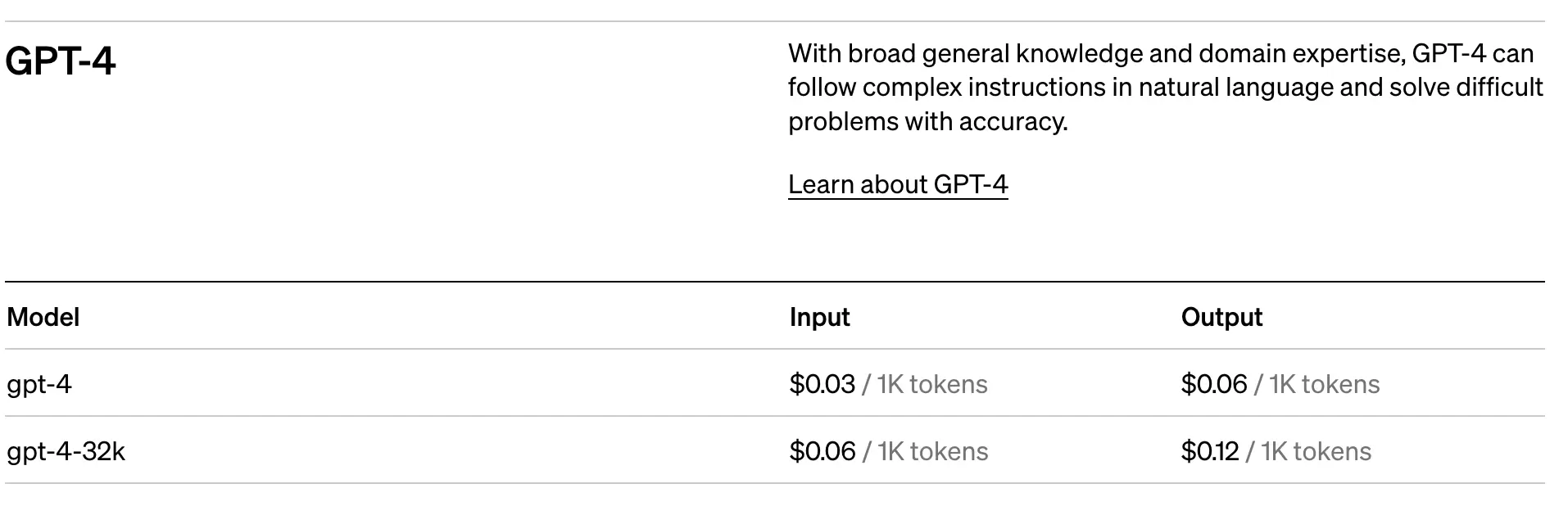

Für den Vergleich mit GPT-4 von OpenAI muss man die Leistung entsprechend umrechnen. Denn Groq rechnet in 1 Mio Token-Schritten ab, wo hingehen OpenAI in Tausender-Paketen abrechnet.

Würde ich also das GPT-4-32k Modell mit dem Mixtral8x7B-32k Modell vergleichen, würden 1 Mio Tokens folgendes kosten:

- GPT-4 Input: 60 USD

- GPT-4 Output: 120 USD

- Mixtral (bei Richtungen): 0,27 USD

Ein deutlicher Unterschied!

Wie sieht die Qualität im Vergleich aus?

Ein echter Vergleich ergibt in einem Blogpost wie diesem recht wenig Sinn. Denn LLMs sind lernende Modelle und werden jeden Tag besser. Dazu kommt, dass die Qualität des Outputs auch stark von der Qualität des Inputs abhängt, also dem Prompten.

Meine aktuellen Erfahrungen sind, dass GPT-4 qualitativ weiterhin die beste Option bietet, um Content zu erstellen. Deshalb nutze ich das Tool auch weiterhin in meiner SEO KI Blog Engine.

Für Bilder bin ich mittlerweile großer Fan von Adobe Firefly* und Midjourney V6.

Was die Recherche angeht, ist Google's Gemini die beste Option.

So unterschiedlich wie die Anwendungsfälle sind, so unterschiedlich sind auch die LLMs, die mal bessere und mal schlechtere Ergebnisse erzeugen.

Mein Tipp ist daher, auszuprobieren und eigene Erfahrungen zu machen.

In der Praxis empfehle ich, einzelne Aufgaben mithilfe unterschiedlicher KI Modelle umzusetzen und Prozesse zu automatisieren. Damit lassen sich nicht nur Ergebnisse verbessern, sondern auch Kosten optimieren.

Kein Spam, keine Weitergabe an Dritte. Nur du und ich.